Cualquiera que considere métodos aritméticos para producir dígitos aleatorios está, por supuesto, en pecado mortal . John von Neumann

Normalmente se dice que una sucesión de números es aleatoria si en ella no se aprecian regularidades ni patrones. En estadística el concepto de aleatoriedad es de gran importancia a la hora de seleccionar muestras, en los procesos de simulación o en el método de Montecarlo. Para asegurar que un proceso es aleatorio la estadística ha elaborado multitud test de aleatoriedad, que consisten en unas pruebas para decidir si en un conjunto de datos existen patrones o no. Test de rachas, estudio de correlación, test de dependencia temporal, etc.

No obstante, algunas veces, los resultados de un cierto número de lanzamientos de un dado o una ruleta, son difíciles de reconocer, como aleatorios porque, con frecuencia, se encuentran en ellos patrones y relaciones. En un experimento aleatorio, si lanzamos una dado quince veces, pueden obtenerse los resultados A y B:

A = {1,1,1,1,1,2,2,2,2,2,3,3,3,3,3} o B ={3,1,5,2,6,3,4,2,5,1,4,2,6,5,3}

Tanto A como B, son resultados de un experimento aleatorio, sin embargo, A nos parece más aleatorio que B, porque en A observamos patrones repetitivos.

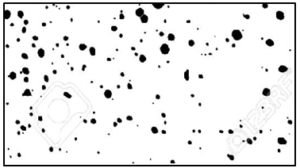

Leibniz (1646-1716) en su Metafísica daba un ejemplo que relacionaba la complejidad con el azar: las manchas de tinta dispersadas al azar cuando se sacude un pincel mojado en tinta sobre un papel

Las manchas se habían producido al azar, pero se podían relacionar entre sí mediante si se observan patrones entre algunas; e incluso, en ocasiones, se podían encontrar polinomios interpoladores tipo de Lagrange que relacionaran entre si cierto número de puntos, lo que significaba que existía una ley matemática que relacionaba elementos generados al azar

Las manchas de tinta podían presentar diferentes grados de dispersión. Si las manchas estaban alineadas el polinomio de interpolación sería de primer grado por ser una línea recta. Podemos pe nsar que el grado del polinomio de interpolación y el número de polinomios que se precisen para expresar relaciones entre diferentes puntos nos da una idea de la complejidad del conjunto de manchas y que esa complejidad está relacionada con el azar. Para Leibniz la aleatoriedad tenía grados y si la fórmula matemática era complicada o hacían falta varias fórmulas, los puntos tenían una distribución más aleatoria que cuando la fórmula era simple.

nsar que el grado del polinomio de interpolación y el número de polinomios que se precisen para expresar relaciones entre diferentes puntos nos da una idea de la complejidad del conjunto de manchas y que esa complejidad está relacionada con el azar. Para Leibniz la aleatoriedad tenía grados y si la fórmula matemática era complicada o hacían falta varias fórmulas, los puntos tenían una distribución más aleatoria que cuando la fórmula era simple.

La idea aportada por Leibniz relacionaba los fenómenos aleatorios con la complejidad y con lo computable en el sentido de que ente una disposición de puntos, que se suponía aleatoria encontrar una ley matemática que cumlía el conjunto entero de manchas o una partesdel mismp , a veces se encontraba una fórmula como la siguiente que relacionaba n puntos (xi, yi), lo que suponía :

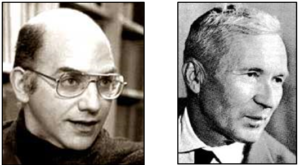

Las ideas de Leibniz sobre las relaciones entre complejidad y aleatoriedad fueron retomadas por G. Chaitin (n.1947) y A. N. Kolmogorov (1903-1987) que en los años sesenta del siglo XX. Ambos matemáticos dieron, de forma simultánea e independiente, una definición de aleatoriedad basada en la complejidad, conocida como aleatoriedad algorítmica o computacional.

En la filosofía tradicional se aceptaba que todos sucesos que ocurren en la naturaleza y en el mundo son efecto del azar y de la necesidad. Chaitin y Kolmogorov profundizaron en esta línea filosófica identificando la complejidad máxima con lo aleatorio en estado puro. Y mostrando que en otras complejidades aparecen mezclados el azar y la necesidad.

La aleatoriedad algorítmica de una sucesión numérica se asocia a la longitud del programa informático más corto que genera esa sucesión.

Por ejemplo, decimos que una sucesión de ceros y unos, no es aleatoria si se puede comprimir. Es decir, si existe un algoritmo o programa informático que, expresado en sistema binario, es más corto que la sucesión y ejecutándolo devuelve como resultado la secuencia larga. Se dice entonces que la sucesión breve contiene la información de la sucesión larga de forma comprimida.

Por lo tanto llegamos a la definición algorítmica de aleatoriedad. Una sucesión se llama aleatoria si no es compresible, esto es, si no existe otra sucesión más corta de números (un programa más corto) que la determine.

Ejemplo1

La sucesión: 001001001001001001001001001001001001001001001001001001001001 no es aleatoria, ya que se puede expresar de forma más breve como como “001 veinte veces”,

Ejemplo 2

La sucesión: 11001010111001111011010001000001111111100110000011100000001 es aleatoria, ya que (en principio) no puede comprimirse.

La compresión se realiza con información y es precisamente la compresión la propiedad informática permite reducir la cantidad de información necesaria para almacenar un archivo.

Sucesión larga = Programa (sucesión corta) + Información

Ejemplo 3 La sucesión:

1415926535 8979323846 2643383279 5028841971 6939937510 5820974944

5923078164 0628620899 8628034825 3421170679 8214808651 3282306647

1415926535 8979323846 2643383279 5028841971 6939937510 5820974944

5923078164 0628620899 8628034825 3421170679 8214808651 3282306647

parece aleatoria, pero no lo es, ya que son los doscientos cuarenta primeros decimales de π, y, por lo tanto no serán aleatorios según la definición de Chaitin_Kolmogorov, porque hay un programa más corto que genera, no solamente esas cifras, sino millones de ellas .

Es como si el azar fuera la medida de nuestra ignorancia moviéndose entre la complejidad. Chaitin ha demostrado que decidir si una sucesión de números es o no aleatoria es en general indecidible, en el sentido de Gödel y Turing. No existe un algoritmo general que, aplicado a una secuencia arbitraria, arroje un sí o no a la pregunta de si la secuencia es aleatoria.

El problema de esta definición de aleatorio es que reduce el azar a grado de complejidad. En cierto sentido la complejidad podría considerarse semejante al azar y ser producto de la ignorancia, pues desconocemos cómo funciona un sistema complejo.